Pesquisadores da Big Science AI apresentam ‘ BLOOM ‘ de código aberto. Um grande modelo de linguagem multilíngue autorregressivo maior que GPT-3 e OPT-175. Neste artigo você irá conhecer melhor sobre isso

Os modelos de linguagem são sistemas de inteligência artificial (IA) cujos principais usos envolvem a linguagem natural (isto é, humana). Assim, eles poderiam responder a perguntas, fazer frases, descobrir como alguém se sente, resumir, simplificar ou traduzir texto.

Os Modelos de linguagem grande (LLM) são algoritmos construídos por aprendizado profundo em enormes volumes de dados. Portanto, eles estão entre os campos mais populares de estudo de IA.

A Hugging Face, uma startup de IA franco-americana, iniciou a Big Science na primavera de 2021 para resolver esses problemas treinando um modelo novo chamado BLOOM.

Ele aprende a partir de grandes grupos de textos, chamados corpora, seguindo uma regra simples, que é adivinhar a próxima palavra em uma frase e então compara seu palpite com a palavra real. Pode-se, então, alterar os parâmetros do modelo com base em quão bem ele funciona.

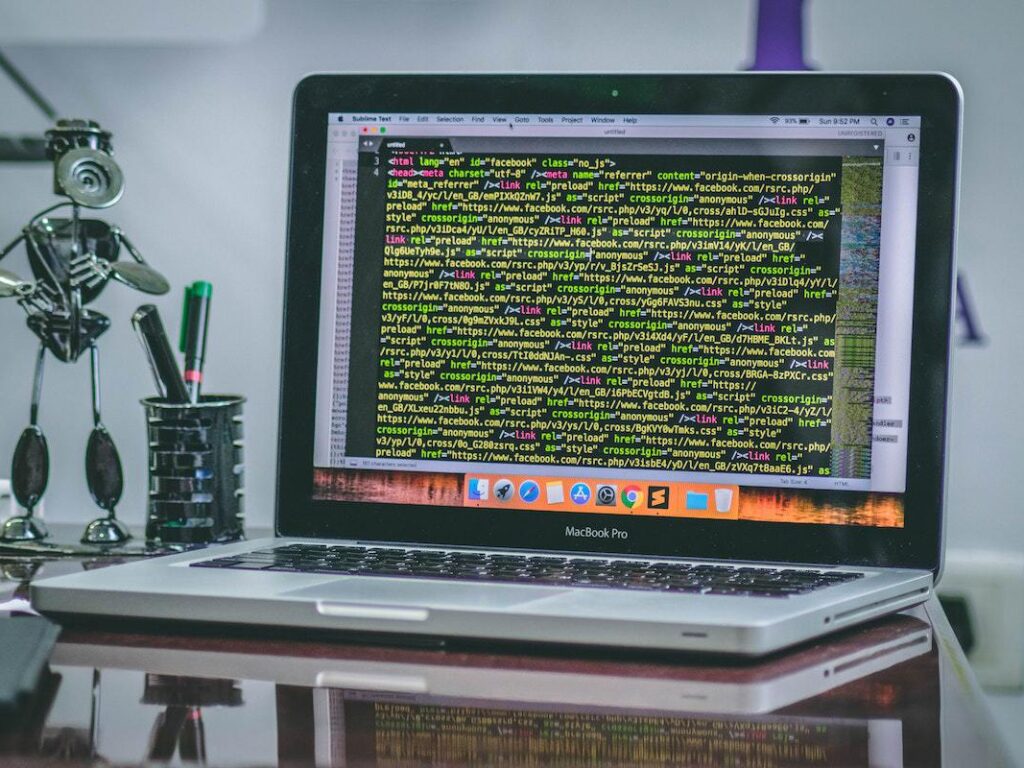

Com 176 bilhões de parâmetros, mais do que o GPT-3 da Open AI e o OPT da Meta AI, o BLOOM pode criar textos em 46 idiomas e dialetos naturais e 13 linguagens de programação.

Ele foi treinado em 1,6 TB de dados de texto, o mesmo que 320 cópias de todas as obras de Shakespeare. Sendo assim, ele consegue atender com 46 idiomas como:

Uns 30% dos dados de treinamento estavam em inglês, segundo a Big Science. Entretanto, o modelo também é proficiente em treze linguagens de programação. Então, essas línguas foram ensinadas ao BLOOM usando literatura, artigos científicos, notícias esportivas, entre outros.

Ele é o único no planeta dos modelos grandes de linguagem, onde outros idiomas são utilizados além do inglês. Portanto, inserir várias línguas pode ajudar muito os cientistas de IA em países carentes. Isso porque eles muitas vezes têm problemas para acessar em sua linguagem natural porque requer muito poder de computação e fica caro.

O BLOOM deixa que eles descartem a parte cara do desenvolvimento e treinamento dos modelos para que possam focar na construção de aplicativos e no ajuste fino dos modelos para tarefas em seus idiomas nativos.